ローカルLLM開発

クラウドに出せないデータをAI対応

機密情報の取り扱いなどの理由からクラウド上のLLMを利用できないケースに向けて、ツール連携可能なローカルLLMを用いたAIシステムを提供しています。

ハードウェア、通信、ソフトウェアまでを一気通貫で開発可能なため、現場環境や既存システムに合わせた柔軟かつ迅速な対応が可能です。

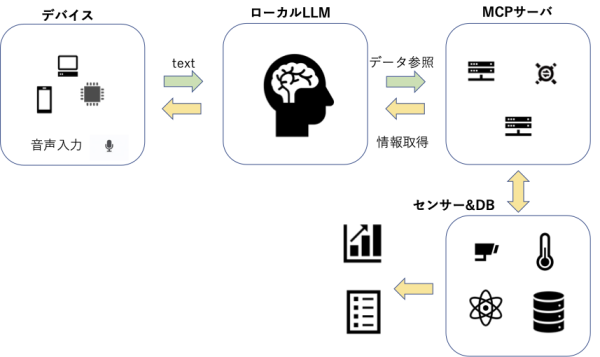

ローカルLLMの動作概要

弊社のローカルLLMは、以下のような流れで動作します。

- ユーザーの音声入力をテキスト化します。

- テキストを、LLMにて解析、処理します。

- センサー情報が必要な場合は、ローカルMCPサーバに問い合わせ、取得したセンサー情報を考慮した回答を生成します。

- データベースの参照が必要な場合も、ローカルMCPサーバを通じてDB内容を考慮した回答を生成します。

- LLMの出力は、テキスト表示、音声出力、Webページ表示、ツール起動など、利用シーンに応じた分かりやすい形で提供します。

なお、LLMは学習済みのものを利用し、言語理解と判別用途として利用し、実際の動作や制御はMCPを通して行うことで、安全性を確保しています。

ハルシネーション対策について

LLMによる根拠が不明確な回答(ハルシネーション)への対策として、センサー情報やデータベース情報は、別ウィンドウ等で根拠を明示した形で表示する設計としています。

よくある悩み・困りごと

ローカルLLMにより、以下のような課題を解決できます。

- ChatGPTを業務で使いたいが、情報漏洩が怖い

- クラウド上のAIサーバを使いたいが、機密情報のため、利用できない

- 工場、医療現場、工事現場などネットワーク環境が不安定な場所でAIを使いたい

- BLE,Wi-Fi,NFCなどから取得したセンサー情報をAIで処理したい

- エラーログや運用ログをAIで解析したい

- AIを導入したいが、ブラックボックス化や、ベンダーロックインを回避したい

ユースケース

具体的な使用例として、以下のようなケースがあります。

- 機密情報を扱うサーバから情報を取得し、外部に出さずにAI処理を実施

- 工場などキーボード操作が難しい現場で、音声によるセンサー情報収集・確認

- 社内文書・ログ・マニュアルを対象とした検索AI